확률 분포를 서술하는데 있어서 방향성 그래프를 어떻게 사용하는지 1.2.6절에서 사용한 베이지안 다항 회귀 모델을 고려해보자.

베이지안 다항 회귀 모델의 확률 변수는 다음과 같다.

- $\mathbf{w}$ : 다항 계수(가중치)의 벡터

- $\mathbf{t}=\left(t_{1}, \ldots, t_{N}\right)^{\mathrm{T}}$ : 관측된 데이터

베이지안 다항 회귀 모델의 입력 데이터 및 hypyer-parameter(초매개변수)는 다음과 같다.

- $\mathbf{x}=\left(x_{1}, \ldots, x_{N}\right)^{\mathrm{T}}$ : 입력 데이터

- $\sigma^{2}$ : 노이즈 분산

- $\alpha$ : $\mathbf{W}$에 대한 gaussian 사전 분포의 정밀도

일단, 지금은 확률 변수들에만 초점을 두고 설명한다. 이 경우 결합 분포는 사전 분포 $p(\mathbf{w})$ 와 $N$개의 조건부 분포 $p\left(t_{n} \mid \mathbf{w}\right) \text { for } n=1, \ldots, N$ 의 곱으로 표현된다.

$$p(\mathbf{t}, \mathbf{w})=p(\mathbf{w}) \prod_{n=1}^{N} p\left(t_{n} \mid \mathbf{w}\right) \tag{식 8.6}\label{eq1}$$

이 결합 분포를 표현하면 Figure 8.3 그래프 모델과 같다.

|

하지만, $t_{1}, \ldots, t_{N}$과 같은 여러 개의 노드를 그리려면, 더 복잡한(변수들이 더 많은) 모델을 다룰 때 불편할 것이다. 따라서 이런 여러 노드들을 더 간결하게 표현하기 위해 하나의 대표 노드$t_n$을 그리고 이를 판(plate)이라 불리는 상자로 둘러쌀 것이다. 그리고 상자에는 $N$(이러한 node가 $N$개 존재한다는 의미)이라는 라벨을 붙인다. Figure 8.4 그래프 모델

|

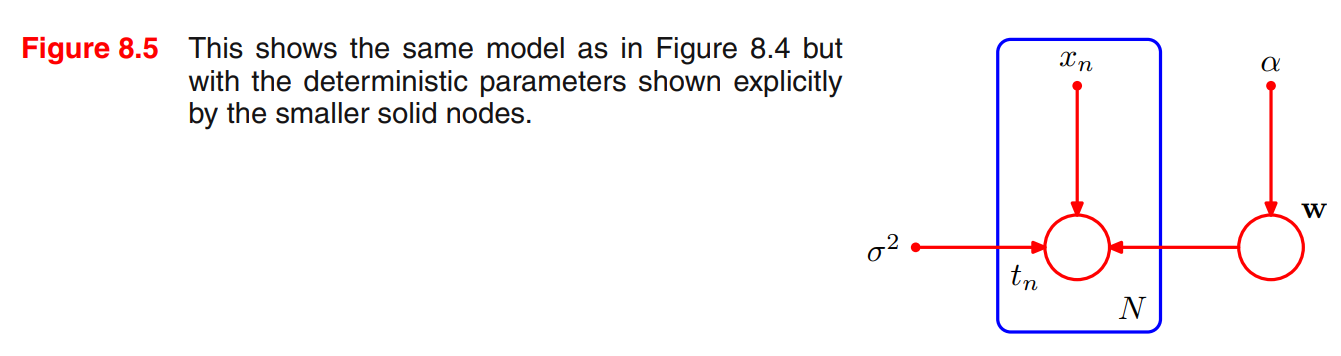

때로는 모델의 매개변수나 확률 변수들을 직접적으로 표현하는 것이 편리할 수도 있다.

$$p\left(\mathbf{t}, \mathbf{w} \mid \mathbf{x}, \alpha, \sigma^{2}\right)=p(\mathbf{w} \mid \alpha) \prod_{n=1}^{N} p\left(t_{n} \mid \mathbf{w}, x_{n}, \sigma^{2}\right) \tag{식 8.6}\label{eq2}$$

이에 맞게 $\mathbf{x}$와 $\alpha$를 그래프에서도 직접 표현할 수 있다. (tip : 확률변수들은 열린 원으로 표기, 매개변수들은 작은점으로 표기)

|

머신러닝이나 패턴 인식 문제에 그래프 모델을 적용할 때, 몇몇 확률 변수들을 특정 관측값으로 설정하게 되는데, 다항식 곡선 근사의 경우에는 훈련 집합의 변수 ${t_n}$이 그 예시이다. 그래프 모델에서 이러한 관측 변수(observed variable)들은 해당 노드에 음영을 추가함으로써 표현한다.

- $\mathbf{w}$ : 잠재 변수 (latent, 은닉 변수라고도 불림) , 관측 대상이 아님

- $\mathbf{t}$ : 관측 변수 (observed variable)

|

참고로 잠재 변수들은 많은 확률적 모델에서 중요한 역할을 담당하고 있으며, 앞으로 9장, 12장에서 중요하게 다룰 예정이다.

${t_n}$ 값들을 관측한 상황에서, 만약 원한다면 1.2.5절에서 다뤘던 것과 같이 다항 계수 $\mathbf{W}$의 사후 분포를 계산할 수 있다. 일단, 여기서는 이 과정이 베이지안 정리를 직접적으로 적용한다는 것을 포함한 것을 확인하고 넘어가자

$$p(\mathbf{w} \mid \mathbf{T}) \propto p(\mathbf{w}) \prod_{n=1}^{N} p\left(t_{n} \mid \mathbf{w}\right) \tag{식 8.7}\label{eq3}$$

표기를 간략하게 하기 위해서 결정적 매개변수들은 생략함

일반적으로 최종 목표인 새로운 입력 변수에 대해서 예측을 하는 것이기 때문에 $\mathbf{w}$와 같은 모델 매개변수들 그 자체로는 흥미롭지 않다. 새로운 입력 변수 $\widehat{x}$가 주어졌을 때, 관측 데이터를 조건부로 하는 $\widehat{t}$에 대한 확률 분포를 구한다고 가정해 보자. 이 문제를 기술하는 그래프 모델이 Figure 8.7에 그려져 있으며, 이 모델의 모든 확률 변수들에 대한 결합 분포(매개변수들은 조건부로 가지는)는 다음과 같이 주어진다.

$$p\left(\widehat{t}, \mathbf{t}, \mathbf{w} \mid \widehat{x}, \mathbf{x}, \alpha, \sigma^{2}\right)=\left[\prod_{n=1}^{N} p\left(t_{n} \mid x_{n}, \mathbf{w}, \sigma^{2}\right)\right] p(\mathbf{w} \mid \alpha) p\left(\widehat{t} \mid \widehat{x}, \mathbf{w}, \sigma^{2}\right) \tag{식 8.8}\label{eq4}$$

위에서 함축적으로 확률 변수 $\mathbf{t}$를 데이터 집합에서 관측된 특정값으로 설정하였으며, 계산에 대한 자세한 내용은 3장을 참고하자.

|

'패턴인식과 머신러닝 > Ch 08. Graphical Models' 카테고리의 다른 글

| A Tutorial on Learning With Bayesian Networks (0) | 2020.07.28 |

|---|---|

| 8.1.3 Discrete variables (이산 변수) (0) | 2020.07.07 |

| 8.1.2 Generative models (생성적 모델) (0) | 2020.07.07 |

| 8.1 bayesian network (0) | 2020.07.07 |

| CH 8. Graph Model (0) | 2020.07.07 |

댓글