세 개의 확률 변수 $a$, $b$, $c$에 대한 임의의 결합 분포 $p(a, b, c)$를 고려해 보자. 여기서 이 변수들에 대해서 아무것도 특징짓지 않는다는 것을 주목해보자. (이 변수들이 이산인지 또는 연속인지 특정짓지 않음) 이러한 그래프 모델의 강력한 측면 중 하나는 하나의 특정 그래프가 넓은 범위의 분포들에 대한 확률적인 표현으로 사용될 수 있다는 점이다.

확률의 곱 법칙을 적용하면 결합 분포를 다음과 같이 나타낼 수 있다.

$$p(a, b, c)=p(c \mid a, b) p(a, b) \tag{식 8.1}\label{eq1}$$

식 8.1의 오른쪽 두 번째 항에 곱의 법칙을 한번더 적용하면 다음과 같이 나타낼 수 있다.

$$p(a, b, c)=p(c \mid a, b) p(b \mid a) p(a) \tag{식 8.2}\label{eq2}$$

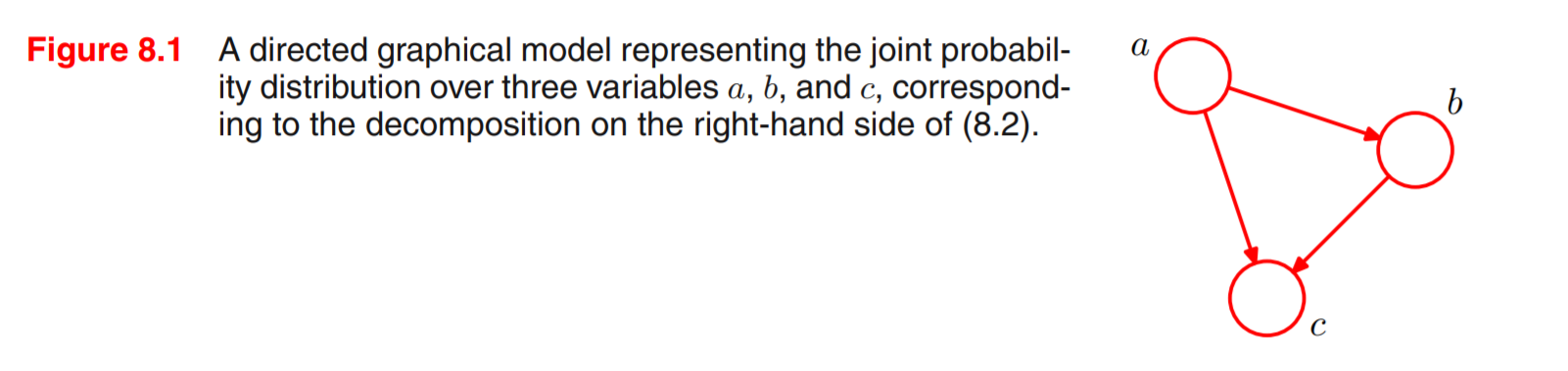

이처럼 결합분포를 곱의 법칙을 이용한 분해는 어떤 종류의 결합 분포에 대해서든 적용할 수 있다. 이제 식 8.2의 오른쪽 변을 단순한 그래프 모델로 표현해 보자.

|

- 각각의 확률 변수 $a, b, c$에 대한 노드 정의

- 각 노드를 식 8.2의 오른쪽 변의 조건부 분포들과 연관시킬 것

- 각각의 조건부 분포에 대해서 방향성 링크를 그래프에 추가 (이 링크는 조건부 분포의 조건절의 변수에 해당하는 노드로부타 시작된느 화살표로 그려지게 된다)

따라서 인자 $p(c|a,b)$의 경우에는 부모(parent) 노드 $a$와 $b$로부터 자식(child) 노드 $c$로 링크를 그리게 될 것이다.

|

같은 방법으로 $p(b|a)$의 경우에는 부모 노드 $a$로부터 자식(child) 노드$b$로 링크를 그리게 될 것이다. (

|

반면, 인자 $p(a)$의 경우에는 들어오는 링크가 없기 때문에 다음과 같이 그대로 나둔다.

|

여기서는 노드와 노드에 해당하는 변수 간에 형식적인 구별을 하지 않을 것이며, 같은 기호를 통해 둘 다 지칭할 것이다.

식 8.2에서 흥미로운 것은 왼쪽변은 $a, b, c$ 세 개의 변수에 대해서 대칭적인 반면, 오른쪽 변은 비대칭적이다. (비대칭이라는 의미 : 곱의 법칙을 통해 분해하는 과정에서 암묵적으로 특정 순서($a, b, c$)임를 선택함), 만약 다른 순서를 선택했더라면 다른 분해 결과를 얻었을 것이고, 따라서 해당 그래프 표현 또한 달라졌을 것이다. 이 부분에 대해서는 추후 다시 살펴볼 예정이다.

그림 8.1의 예시를 $K$개 변수에 대한 결합 분포 $p\left(x_{1}, \ldots, x_{K}\right)$의 경우로 확장해 보자. 확률의ㅏ 곱의 법칙을 반복적으로 적용해서 이 결합 분포를 조건부 분포들의 곱으로 표현할 수 있다.

$$p\left(x_{1}, \ldots, x_{K}\right)=p\left(x_{K} \mid x_{1}, \ldots, x_{K-1}\right) \ldots p\left(x_{2} \mid x_{1}\right) p\left(x_{1}\right) \tag{식 8.3}\label{eq3}$$

선택된 $K$에 대해서 해당 결합 분포를 $K$개의 노드를 가지는 방향성 그래프로 표현할 수 있다. 이처럼 자신보다 낮은 순번의 노드들로부터 들어오는 방향의 링크를 가지게 되는데, 이 경우 그래프는 완전 연결(fully connected)되었다고 표현한다. (모든 노드 쌍 사이에 연결이 존재함)

지금까지 일반적인 결합 분포를 바탕으로 살펴보았다. 이 경우의 분해 결과와 이를 표현하는 완전 연결된 그래프는 어떤 분포에 대해서든지 적용할 수 있다. 사실 그래프에서 부재(absence)하는 링크가 해당 그래프가 표현하는 분포에 대한 흥미로운 정보를 전달하게 된다. 그림 8.2의 그래프를 살펴보면, 완전 연결된 그래프가 아니다.

|

$$p\left(x_{1}\right) p\left(x_{2}\right) p\left(x_{3}\right) p\left(x_{4} \mid x_{1}, x_{2}, x_{3}\right) p\left(x_{5} \mid x_{1}, x_{3}\right) p\left(x_{6} \mid x_{4}\right) p\left(x_{7} \mid x_{4}, x_{5}\right) \tag{식 8.4}\label{eq4}$$

잠시 시간을 두고 식 8.4 와 식 8.2 간의 연관성을 유심히 살펴보길 바란다.

이제 주어진 방향성 그래프와 이에 해당하는 변수들의 분포 사이의 관계성을 알 수 있다. 그래프를 바탕으로 정의된 결합 분포는 모든 노드에 대한 조건부 분포들의 곱으로 주어지게 된다. 이 때 각 노드에 대한 조건부 분포는 그래프에서의 부모 노드에 대해 조건부인 분포다. 따라서 $K$개의 노드를 가지는 그래프의 경우에 결합 분포는 아래처럼 주어진다.

$$p(\mathbf{x})=\prod_{k=1}^{K} p\left(x_{k} \mid \mathrm{pa}_{k}\right) \tag{식 8.5}\label{eq5}$$

- $\mathrm{pa}_{k}$ : $x_k$의 부모 노드

- $\mathbf{x}=\left\{x_{1}, \ldots, x_{K}\right\}$

식 8.5의 핵심은 방향성 그래프 모델에서의 결합 분포의 인수분해(factorization) 성질을 표현하고 있다는 것이다.

지금까지 다룬 방향성 그래프는 "방향성 순환(directed cycle)이 없어야 하는" 중요한 제약을 가지고 있다. 원래의 노드로돌아오게 되는 순환 경로가 그래프상에 존재해서는 안 된다는 것이다. 이러한 그래프를 뱡향성 비순환 그래프(directed acycle graph, DAG)라고 부르기도 한다.

- "Bishop: Pattern Recognition and Machine Learning"을 참고하여 작성한 자료

'패턴인식과 머신러닝 > Ch 08. Graphical Models' 카테고리의 다른 글

| A Tutorial on Learning With Bayesian Networks (0) | 2020.07.28 |

|---|---|

| 8.1.3 Discrete variables (이산 변수) (0) | 2020.07.07 |

| 8.1.2 Generative models (생성적 모델) (0) | 2020.07.07 |

| 8.1.1 Example: Polynomial regression (다항 근사) (0) | 2020.07.07 |

| CH 8. Graph Model (0) | 2020.07.07 |

댓글